来源:安森美 作者:高级总监,Aditya Jian

在加密货币和人工智能/机器学习(AI/ML)等新兴应用的驱动下,数据中心的能耗巨大,并将快速增长以满足用户需求。根据国际能源署(IEA)的最新报告,2022 年数据中心的耗电量将达到 460 TWh(太瓦时),约占全球总用电量的 2%。在美国,拥有全球三分之一的数据中心,耗电量为 260 TWh,占总用电量的 6%。

预测未来具有挑战性,这取决于部署了多少非常耗电的图形处理单元(GPU)来应对人工智能技术的需求,当然还取决于进一步增加空调来降低数据中心的温度。国际能源署的报告显示,到 2026 年,数据中心的耗电量将至少增长到 650 TWh(40%),但也可能高达 1,050 TWh(128%)。

数据中心支持人工智能趋势

人工智能是一项极其耗电的技术,支持其运行的数据中心需要具备足够的算力和电力输送能力。

瑞典RISE研究机构最近的一项研究清楚地展示了由于该技术迅速普及所带来的巨大变化。例如,ChatGPT在2022年11月推出后仅五天内就达到了100万用户。他们在两个月内就拥有了 1 亿用户,而TikTok达到同一用户量级用了9个月,Instagram则用了两年半的时间。

作为参考,在谷歌上进行一次搜索仅需 0.28 Wh,相当于让一个60W的灯泡亮17秒。

相比之下,训练 GPT-4 需要 1.7 万亿个参数和 13 万亿个tokens(单词片段),这是一个完全不同的命题。要做到这一点,需要包含 25,000 个英伟达 A100 GPU的多台服务器,每台服务器的功耗约为 6.5 kW。OpenAI 表示,训练耗时 100 天,耗能约 50 GWh,耗资 1 亿美元。

显然,人工智能将极大地改变数据中心的游戏规则,其所需的计算能力和能耗水平将远远超过我们迄今为止所看到的任何水平。

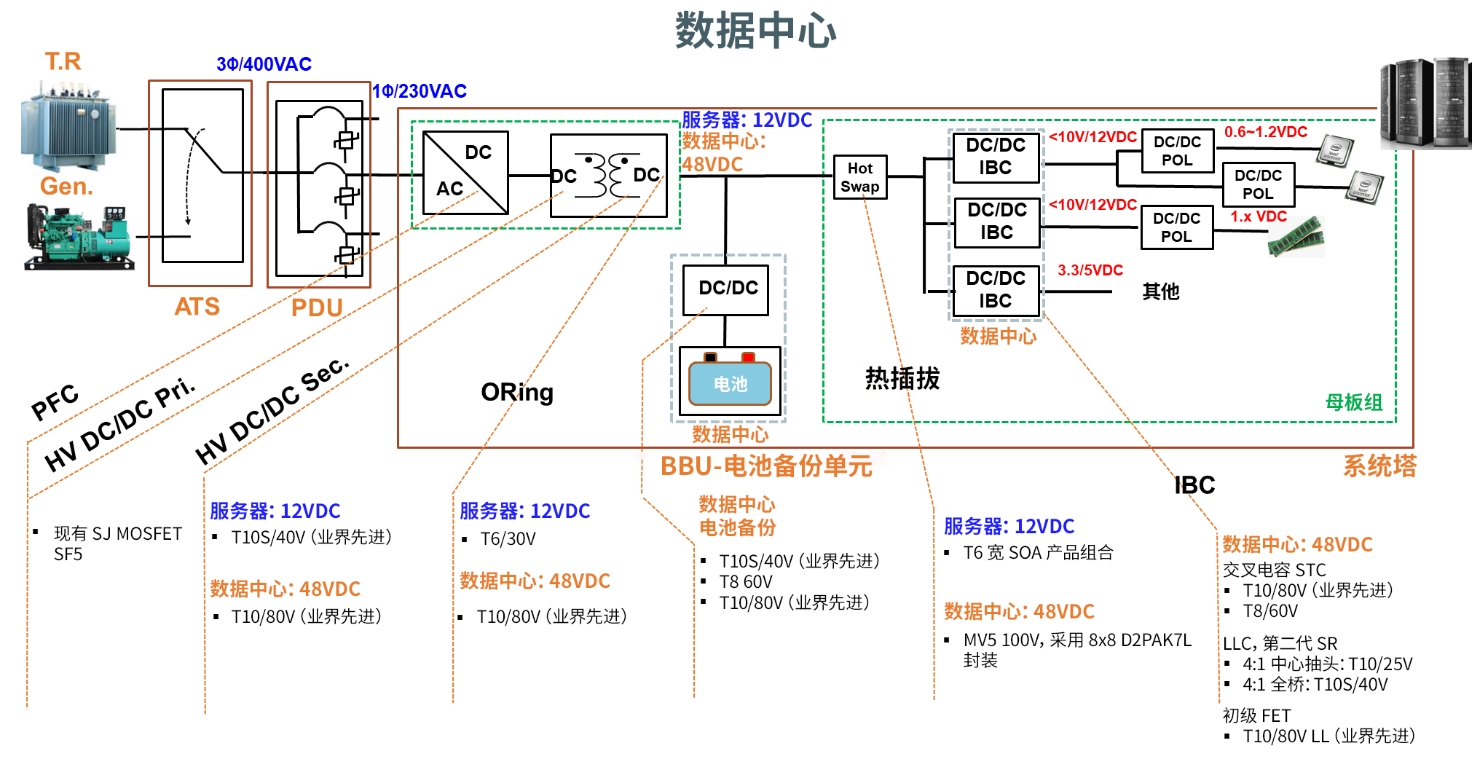

数据中心 48V 架构

早期的数据中心采用集中式电源架构 (CPA),将主电源(电网)电压集中转换为 12V(母线电压),然后将其分配给各服务器,并使用相对简单的转换器在本地将其转换为5V 或 3.3V逻辑电平。

然而,随着功率需求的增长,12V 母线上的电流(以及相关损耗)变得高得令人无法接受,迫使系统工程师改用48V 母线布置。根据欧姆定律,电流减少了 4 倍,损耗则降低了 4 倍的平方。这种配置被称为分布式电源架构 (DPA)。

与此同时,处理器和其他一些元器件的电压也在不断降低,最终降至亚伏特级别,导致需要多个次级电压轨。为解决这一问题,采用了二阶转换技术,通过DC-DC转换器(称为中间母线转换器 - IBC)将 48V 电压转换为 12V 母线,再根据需要从 12V 母线输出其他电压。

对高能效 MOSFET的需求

数据中心内部的电力损耗给运营商带来了挑战。首先,也是最明显的一点是,他们正在为那些无助于服务器运行的电力付费。其次,任何浪费的能源都会转化为热量,这就必须设法处理。由于超大规模AI服务器的功率需求高达 120 kW(而且肯定会随着时间推移而增加),即使在 50% 负载的情况下,以 97.5% 的峰值效率计算 2.5% 的损耗,每台服务器也会浪费 1.5 kW的电力,相当于一台全时运行的电加热器。

处理热量可能需要在功率转换系统中采取散热措施,如散热器或风扇。这些措施会增大电源的体积,占用本可用于更多计算能力的空间,就风扇而言,还会耗费电能并增加成本。由于数据中心内的温度需要严格控制,过高的损耗也会使环境温度升高,这意味着需要更多的空调来降温。这既是资本支出,也是运营成本,同时还占用空间。

显然,尽可能高效地将主(电网)电压转换为驱动人工智能 GPU 和其他设备供电所需的电压,对数据中心运营商来说大有裨益。

因此,多年来人们在电源拓扑结构方面做了大量工作,在前端 PFC 阶段引入了图腾柱PFC (TPPFC) 等技术,以提高其效率。此外,为了提高效率,二极管整流器已被 MOSFET 所取代,并引入了同步整流等技术。

优化拓扑结构只是其中的一半,要优化效率,所有元件也必须尽可能高效,尤其是对转换过程至关重要的 MOSFET。

当 MOSFET 用于开关电源转换时,主要有两种形式的损耗:导通损耗和开关损耗。导通损耗由漏极和源极之间的电阻(RDS(ON))造成,在电流流动时一直存在。开关损耗是由栅极电荷 (Qg)、输出电荷 (QOSS) 和反向恢复电荷 (Qrr) 共同造成的,这些电荷在每个开关周期都会得到补充。由于目前的趋势是提高开关频率以减小磁性元件的尺寸,因此随着补充频率的增加,这种损耗也会变得相当显著。

显然,特定 MOSFET 的导通损耗和开关损耗越低,电源系统的整体转换效率就越高。

PowerTrench T10 MOSFET 简介

同步整流现在已成为所有高性能、大电流、低压电源转换应用中的关键技术,特别是在数据中心服务器的应用中更是如此。在这种应用中,包括RDS(ON)、Qg、QOSS和Qrr在内的几个MOSFET参数会直接影响转换效率,器件制造商正努力寻求减小这些影响的方法。

安森美的 PowerTrench T10 MOSFET 采用新型屏蔽栅极沟道设计,实现了超低的 Qg 值,且 RDS(ON) 低于 1mOhm 。最新的 PowerTrench T10 技术不仅减少了振铃、过冲和噪声,其业界先进的软恢复体二极管还降低了 Qrr。这在导通电阻性能和恢复特性之间实现了良好的折中平衡,同时还可实现具有良好反向恢复特性的低损耗快速开关。

总体而言,PowerTrench T10 器件在参数方面的改进提高了中低压、大电流开关电源解决方案的效率。通常情况下,开关损耗比上一代器件最多可降低 50%,而导通损耗可降低 30%-40%。

安森美推出了PowerTrench T10技术的40V系列和80V系列产品。NTMFWS1D5N08X(80V、1.43mΩ、5mm x 6mm SO8-FL 封装)和 NTTFSSCH1D3N04XL(40V、1.3mΩ、3.3mm x 3.3mm 源下双冷却封装)为人工智能数据中心应用中的电源单元(PSU)和中间母线转换器(IBC)提供了同类极佳的效率(FOM)。它们达到了开放式机架(Open Rack) V3 规范要求的 97.5% 的 PSU 效率和 98% 的 IBC 效率。

结语

人工智能革命已经到来,没有人能够完全确定它对数据中心未来的电力输送需求究竟意味着什么。不过,可以肯定的是,一系列新的挑战已经出现。房地产资源稀缺和电网的限制使得很难找到容量充足的新地点。关键 IT 方面的总体电力需求激增,给电力成本带来沉重负担。为了满足这些需求,数据中心业主不仅要建设新设施,还要将现有设施推向极限,力求实现每平方英尺兆瓦级的高密度配置。

随着功率水平肯定会超过 100 kW,功率转换将成为关键重点,以实现高效运行,确保散热,可靠地提高功率密度,并在狭窄的现代数据中心中节省空间。

安森美的 PowerTrench T10 技术提供了业界先进的 RDS(ON)、更高的功率密度、降低开关损耗,以及更好的热性能,从而降低总系统成本。PowerTrench T10 等创新功率半导体技术将成为未来的关键组成部分。

免责声明: 本文章转自其它平台,并不代表本站观点及立场。若有侵权或异议,请联系我们删除。谢谢! Disclaimer: This article is reproduced from other platforms and does not represent the views or positions of this website. If there is any infringement or objection, please contact us to delete it. thank you! |